Wissen für Sie

Sie möchten gerne regelmäßig über Neuigkeiten informiert werden? Dann tragen Sie bitte Ihre Daten in untenstehende Felder ein.

Februar 2017

Fördert das Teilen von Rohdaten klinischer Studien Transparenz oder Forschungsparasitismus?

Das International Committee of Medical Journal Editors’ (ICMJE) plant, die verbindliche Freigabe von Rohdaten klinischer Studien zur Voraussetzung für die Veröffentlichung in wissenschaftlichen Zeitschriften zu machen ...

... weiterlesen

Das International Committee of Medical Journal Editors’ (ICMJE) plant, die verbindliche Freigabe von Rohdaten klinischer Studien zur Voraussetzung für die Veröffentlichung in wissenschaftlichen Zeitschriften zu machen. Dieses Vorhaben rief in der wissenschaftlichen Gemeinde gemischte Reaktionen hervor. Auf den ersten Blick hat das Teilen von Rohdaten („data sharing“) das Potential, die medizinischen Wissenschaften voranzubringen und Transparenz zu fördern. Allerdings sind nicht alle Forscher begeistert von der Vorstellung, ihre Daten zu teilen. Dieser Artikel befasst sich mit einigen Bedenken und Ideen bezüglich der Regulierung des Zugangs zu Rohdaten, die seit dem Vorschlag der ICMJE geäußert wurden.

Vorteile der Veröffentlichung von Rohdaten:

- Unabhängige Überprüfung von Studienergebnissen

- Neue Erkenntnisse aus sekundären Analysen

- Daten zur Entwicklung und Erprobung neuer Hypothesen

- Vermeidung unnötiger Wiederholungen von Experimenten

- Genauere Meta-Analysen aus Originaldaten von vergleichbaren Studien werden möglich

Mögliche Probleme der Veröffentlichung von Rohdaten:

- Aufbereitung und Präsentation der Rohdaten einer komplexen klinischen Studie für nicht-involvierte Forscher erfordert Zeit und Geld, die sonst in weitere Forschungsarbeit fließen könnten

- Die Veröffentlichung sekundärer Analysen , die auf falsch verstandenen Parametern und Datenstrukturen basieren, könnte das Vertrauen in die primären Ergebnisse verringern

- Multiple Analysen eines Datensatzes können dazu führen, dass zufällige Korrelationen gefunden werden, in deren Masse die wirkliche Evidenz untergeht

- Unzureichende Anonymisierung der Rohdaten kann die Privatsphäre der Studienteilnehmer gefährden

- Durch die Veröffentlichung der Rohdaten kann eine Nische für "Forschungsparasiten" entstehen, die die Daten anderer Forscher zum eigenen Vorteil nutzen. Diese könnten beispielsweise Sub-Analysen veröffentlichen, bevor die Original-Forschungsgruppe die Möglichkeit dazu hat, oder versuchen, die ursprünglichen Ergebnisse und Schlussfolgerungen zu diskreditieren

Diesen Bedenken kann durch eine sorgfältige Regulierung des Zugangs zu den Rohdaten Rechnung getragen werden. Einige der vorgeschlagenen Systeme für das Datenmanagement und die Zugangsregulierung werden im folgenden Abschnitt vorgestellt.

Lösungsvorschläge:

Verwaltung der Speicherung und Freigabe von Daten von einer unabhängigen Organisation

- Die Idee des „Data Sharing“ ist nicht neu. Seit 2011 ist das Yale Open Data Access Projekt (YODA) in Betrieb und dient als "vertrauenswürdiger Vermittler", dem Erstautoren ihre Daten anvertrauen und von dem Wissenschaftler einen Datenzugang beantragen können.

Einsetzung eines Komitees zur Prüfung und Entscheidung über Datenzugangsanträge

- Bei YODA können Forscher, die sich für Studiendaten interessieren, einen Antrag auf Dateneinsicht einreichen. Über diesen wird durch die YODA-Wissenschaftler auf der Grundlage einer verblindeten Beurteilung des geplanten Projekts entscheiden. Einige der Kriterien für eine positive Entscheidung sind eine klare wissenschaftliche Fragestellung, die geplanteVeröffentlichung und die Durchführbarkeit der vorgeschlagenen Analysen.

- Das Academic Research Organization Consortium for Continuing Evaluation of Scientific Studies–Cardiovascular (ACCESS CV) schlägt die Bildung eines Komitees zur Prüfung von Anträgen auf Datenzugang vor. Dieses setzt sich aus (nicht an der Originalstudie beteiligten) ACCESS CV-Wissenschaftlern, dem Projektleiter der Originalstudie, einem Statistiker und einem Mitglied des Daten- und Sicherheitsüberwachungsgremiums zusammen. Der Ausschuss überprüft Anträge und gewährt Zugang wenn die Sekundäranalyse "machbar, hypothesenbasiert und nicht redundant ist und von technisch versierten Wissenschaftlern mit einem Plan für die Veröffentlichung geleitet wird."

Sperrfrist nach der Veröffentlichung, die ursprünglichen Autoren Zeit für weitere Analysen und Veröffentlichung von Sub-Analysen garantiert

- Der ICMJE schlägt eine Sperrfrist von sechs Monaten nach der Publikation vor, bevor die Studiendaten veröffentlicht werden.

- Das International Consortium of Investigators for Fairness in Trial Data Sharing befürwortet eine zweijährige Basis-Sperrfrist, die sich für jedes Jahr Gesamtstudiendauer um sechs Monate verlängert. Das Maximum beträgt fünf Jahre.

- ACCESS CV empfiehlt eine Zweijahresfrist, bevor Daten freigegeben werden.

Zusätzliche Anforderungen

- Das internationale Consortium of Investigators for Fairness in Trial Data Sharing empfiehlt, sekundäre Analysen vor der Veröffentlichung von einem unabhängigen Statistiker prüfen zu lassen, um das Vertrauen in die Ergebnisse zu erhöhen. Außerdem sollten die Autoren der Originalstudie von den Autoren der Sekundäranalyse für die Kosten und Mühen entschädigt werden, die bei der Weitergabe der Originaldaten entstehen.

Wo stehen wir jetzt?

Viele der vermeintlichen Probleme durch Data Sharing können durch hohe Standards für die Veröffentlichung von Rohdaten und sekundären Analysen überwunden werden. Dies erfordert jedoch erhebliche Anstrengungen durch Autoren von Erst- und Zweitstudien sowie Gutachter, die in der Planung künftiger klinischer Studien berücksichtigt werden müssen.

Die meisten an der Diskussion beteiligten Wissenschaftler sind sich einig, dass Data Sharing per se eine gute Sache ist. Jedoch gibt es bisher wenige Gemeinsamkeiten hinsichtlich der Ideen zur praktischen Durchführung. In Anbetracht der unterschiedlichen Interessen von einerseits Wissenschaftlern, die jahrelange Arbeit in die Erhebung der Daten investiert haben, andererseits staatlichen Institutionen und der Öffentlichkeit, die die Gehälter der Wissenschaftler in Form von Steuergeldern finanzierten, und nicht zuletzt Studiensponsoren, die Millionen von Euros in die Studie investierten, ist es unwahrscheinlich, dass es in absehbarer Zeit eine Entscheidung zugunsten eines einheitlichen Datenaustausch-Systems geben wird.

Was sind die möglichen Ergebnisse?

Ein einheitliches Data Sharing-System für klinische Studiendaten wäre sicher das fairste Ergebnis für Autoren und Verleger. Die aktuelle Debatte kann jedoch auch zu einem Flickwerk von Data Sharing-Systemen in der medizinischen Publikationslandschaft führen. In diesem Fall könnten Autoren die Auswahl eines Journals zur Publikation ihrer Studie zusätzlich zum Impact und der Zielgruppe des Journals davon abhängig machen, wie mit ihren Daten verfahren wird. Die Position von Zeitschriften mit besonders strikten Data Sharing Richtlinien könnte so geschwächt werden. Trotzdem sieht sich das NEJM dem Data Sharing verpflichtet: "Sobald geeignete Systeme vorhanden sind, benötigen wir eine Verpflichtung unserer Autoren, die den Studienergebnissen zugrundeliegenden Daten innerhalb von sechs Monaten nach ihrer Veröffentlichung zur Verfügung zu stellen."

Post Scriptum: Das Potential öffentlicher Rohdaten wird derzeit im Analysewettbewerb der systolischen Blutdruckinterventionsstudie (SPRINT) ausgelotet, die im April 2017 endet. Es wird spannend zu sehen, was Analysten mit einem solchen Datensatz zusätzlich zu den ursprünglichen Studienbefunden erreichen können.

Autor: Dr. Mario Pahl

... einklappen

Januar 2017

Wer ist’s der seine Studienergebnisse nicht teilt?

In der am 8. November 2016 erschienene Ausgabe des British Medical Journal (BMJ) findet sich ein Artikel namens „60 seconds on TrialsTracker“. TrialsTracker ist eine Webseite, die den Veröffentlichungsstatus ...

... weiterlesen

In der am 8. November 2016 erschienene Ausgabe des British Medical Journal (BMJ) findet sich ein Artikel namens „60 seconds on TrialsTracker“. TrialsTracker ist eine Webseite, die den Veröffentlichungsstatus der bei ClinicalTrials registrierten klinischen Studien der letzten zehn Jahre dokumentiert. Die Webseite schlüsselt die Anzahl registrierter gegenüber publizierten Studien nach Unternehmen bzw. Institut oder Krankenhaus auf.

Der BMJ-Artikel konzentriert sich auf die Rolle der Pharmaunternehmen im Trauerspiel veröffentlichter Studien, denn drei der fünf Einrichtungen mit der geringsten Anzahl an veröffentlichten Studien sind die Pharmaunternehmen Sanofi, Novartis und GlaxoSmithKline. Die zwei anderen Einrichtungen mit der geringsten Anzahl veröffentlichter Studien sind ein staatliches Institut und ein öffentliches Krankenhaus. Dieser Fokus des Artikels deckt sich mit der weitverbreiteten Annahme, dass Pharmaunternehmen nur das veröffentlichen, was in ihre Marketingstrategie passt und Informationen zurückhalten, die dem Patienten helfen könnten, aber keinen monetären Gewinn bringen. Interessanterweise ist auch am anderen Ende der Skala ein Pharmaunternehmen Spitzenreiter, denn Shire hat alle angemeldeten Studien veröffentlicht. Auch wenn der BMJ-Autor diese Tatsache anerkennt, erwähnt er nicht, dass die nächsten 17 Plätze der Einrichtungen mit weitgehend vollständiger Veröffentlichung der angemeldeten Studien ebenfalls von Arzneimittelherstellern belegt werden.

TrialsTracker erlaubt dem neugierigen Nutzer aber, noch tiefer in die Materie einzudringen. Dazu kann man die Reihenfolge der Institutionen nach dem Prozentsatz der veröffentlichten zu den registrierten Studien sortieren. Jetzt belegen Arzneimittelhersteller die ersten 22 Plätze und die erste gemeinnützige Organisationfindet sich erst auf Platz 23. Obwohl auch hier am anderen Ende der Skala ein Pharmaunternehmen steht, Ranbaxy Laboratories, das keine einzige registrierte Studie veröffentlicht hat, sind die nächsten 15 schlechtesten Performer in Bezug auf den Prozentsatz der veröffentlichten zu den registrierten Studien allesamt Universitäten, Krankenhäuser und staatliche Institute. Bei der Betrachtung des Prozentsatzes der veröffentlichten Studien im Vergleich zu den Registrierten, schneiden Arzneimittelhersteller also deutlich besser ab als bei Betrachtung der absoluten Zahlen.

Ist die Pharmaindustrie also nur Opfer einer voreingenommenen Berichterstattung? Möglicherweise nicht. Die Daten von TrialsTracker basieren ausschließlich auf Studien, die auf der ClinicalTrials-Webseite registriert wurden. Shires Publikationsrate von 100 % scheint aber im Widerspruch zu gängigen Erfahrungen mit klinischen Studien zu stehen, von denen manche aus vielerlei Gründen ohne publizierbare Ergebnisse abgeschlossen werden. Ein kurzer Blick auf die EudraCT Datenbank zeigt, dass Shire dort 153 Studien registriert hat, während es nur 96 Studien auf clinicaltrials.gov sind. Und in der europäischen Datenbank haben einige Studien den Status “Nicht öffentlich zugängig” im Ergebnisbereich. Ob darunter auch nicht publizierte Studien sind, lässt sich nicht sagen, aber möglicherweise schneidet Shire schlechter ab als es auf TrialsTracker aussieht. Es wäre daher sehr wünschenswert, wenn die Europäische Arzneimittelbehörde bald auch die EudraCT-Datenbank jedem oder zumindest TrialsTracker zugänglich machen würde, um mehr Transparenz in die Datenlage zu bringen.

In erster Linie belegen die Daten auf TrialsTracker, dass unveröffentlichte Studien nicht hauptsächlich ein Problem der Pharmaunternehmen sind, sondern vieler Organisationen, die Studien initiieren. Mehr Transparenz ist ein mächtiges Mittel, um die Effektivität der Gesundheitssysteme zu erhöhen und TrialsTracker kann dabei eine wichtige Rolle spielen. Wenn allerdings die Daten dazu dienen, selektiv bestimmte Gruppen bloß zu stellen, könnte dieses Ziel verfehlt werden. Wissenschaft wird durch Versuch und Irrtum vorangetrieben, und dazu gehören auch fehlgeschlagene Versuche, eine Studie zum Abschluss zu bringen. TrialsTracker deckt einen weit verbreiteten Mangel auf, der dringend angegangen werden muss. Wenn nur einzelne Gruppen für eine negative Berichterstattung herausgepickt werden, wird möglicherweise nur eine Atmosphäre der Angst erzeugt, die schlimmstenfalls dazu führt, dass weniger Studien durchgeführt werden.

Autor: Dr. Christoph Messer

... einklappen

August 2016

Fundstücke: Professional medical writing support improves the quality of reporting of randomized controlled trials

Eine Gruppe medizinischer Fachautoren hat die Arbeit unserer Zunft wissenschaftlich untersucht und ihre Ergebnisse auf dem Treffen der International Society for Medical Publication Professionals, in Arlington, USA, präsentiert ...

... weiterlesen

Eine Gruppe medizinischer Fachautoren (Medical Writer) hat die Arbeit unserer Zunft wissenschaftlich untersucht und ihre Ergebnisse auf dem Treffen der International Society for Medical Publication Professionals, in Arlington, USA, präsentiert. Hierzu haben die Autoren wissenschaftliche Artikel auf Einhaltung der Vorgaben des CONSORT-Statements 2 und die Beurteilung der sprachlichen Qualität der Artikel durch wissenschaftliche Gutachter geprüft.

Die Untersuchung zeigte, dass sowohl die inhaltliche als auch die sprachliche Qualität der Publikationen signifikant besser waren, wenn die Arbeit von einem Medical Writer unterstützt wurde.

Das CONSORT-Statement ist eine Sammlung von Empfehlungen zur standardisierten Beschreibung klinischer Studien, die von vielen medizinischen Fachzeitschriften unterstützt und deren Einhaltung oft gefordert wird (http://www.consort-statement.org/). Die Autoren prüften die Vollständigkeit der von CONSORT geforderten Informationen. Hierzu wurden Artikel aus BioMed Central-Zeitschriften geprüft. 110 Publikationen wurden offiziell durch Medical Writer unterstützt, bei 123 Artikeln war das nicht der Fall. Dabei zeigte sich, dass Publikationen, die offiziell durch einen Medical Writer unterstützt wurden, signifikant häufiger mindestens 50% der CONSORT-Forderungen erfüllten (39,1% vs. 21,1%, p<0,05). Dabei war es unerheblich, ob die Studie durch die Industrie unterstützt wurde oder nicht: Publikationen ohne Unterstützung durch einen Medical Writer schnitten in beiden Fällen schlechter ab als Studien, die durch einen Medical Writer unterstützt wurden.

Auch die sprachliche Qualität der durch Medical Writer unterstützten Publikationen war anderen Publikationen signifikant überlegen. Für BioMed Central-Zeitschriften ist die Historie einer Arbeit von der ersten Einreichung bis zur Publikation einsehbar. Aus diesen Daten lässt sich die Beurteilung der englischen Sprache eines Artikels durch die Gutachter ermitteln. Die höchste Kategorie „acceptable“ wurde für 79,6% der Publikationen angegeben, die mit einem Medical Writer erstellt wurden. Andere Publikationen waren hingegen nur in 42,9% der Fälle „acceptable“ (p < 0,05).

Aus der Publikationshistorie von BioMed Central lässt sich auch die Zeit von Ersteinreichung bis Publikation einsehen. An dieser Stelle kommen offenbar die Interessenkonflikte der Autoren zum Tragen, da dieser Punkt in ihrer „Studie“ fast untergeht: Die mittlere Zeit bis zur Publikation betrug bei Beteiligung eines Medical Writers 167 Tage, ohne deren Beteiligung hingegen 136 Tage (p < 0,01). Für die Abstimmung zwischen Medical Writer, Sponsor und klinischen Forschern erscheinen 30 weitere Tage als ein durchaus realistischer Zeitbedarf, um in dieser Dreierkonstellation allen Parteien gerecht zu werden. Im Rahmen des gesamten Zeitbedarfs klinischer Studien dürfte er auch kaum ins Gewicht fallen. Nicht untersucht wurde leider der Zeitbedarf für die Erstellung der Publikation bis zur Einreichung. Es wäre sehr interessant, ob professionelle Unterstützung bei der Erstellung wissenschaftlicher Publikationen nicht nur wie gezeigt die Qualität verbessert, sondern evtl. auch zu einem schnelleren Abschluss eines Publikationsprojekts führt.

Autor: Dr. Aike Schweda

... einklappen

Juli 2016

Was heißt eigentlich „statistisch signifikant“?

Wissenschaft besteht aus Experimenten. Dabei werden viele Dinge gemessen und jede Messung ist in der Regel nicht perfekt sondern mit einem Fehler behaftet ...

... weiterlesen

Wissenschaft besteht aus Experimenten. Dabei werden viele Dinge gemessen und jede Messung ist in der Regel nicht perfekt sondern mit einem Fehler behaftet. In der Medizin kommt erschwerend hinzu, dass nicht immer wieder am gleichen Objekt (einem Patienten) gemessen wird, sondern an vielen verschiedenen. Üblicherweise streuen daher die Messwerte jeder Messung, manchmal sogar sehr weit. Die Frage ist dann, ob zwischen zwei Gruppen streuender Messwerte ein „echter“ Unterschied besteht, wenn z.B. die Mittelwerte der Messungen sich unterscheiden. Ein Maß dafür, wie verlässlich solche Unterschiede sind, ist die statistische Signifikanz.

Was aber sagt uns diese Signifikanz eigentlich? Kann man sich auf statistisch signifikante Ergebnisse verlassen?

Leider kann man die Bedingungen eines medizinischen Experiments nicht besonders gut standardisieren. Patienten sind nicht unendlich verfügbar, man wird kaum einen „identischen“ noch einmal finden oder den gleichen „wiederverwenden“ können, um seine Ergebnisse zu überprüfen. Deshalb benötigen wir ein Maß dafür, wie verlässlich Ergebnisse aus medizinischen Studien einzuschätzen sind, selbst wenn die einzelnen Untersuchungsobjekte in hohem Maße unterschiedliche Daten liefern.

Dazu führt man einen statistischen Test durch. Dieser Test überprüft die Vereinbarkeit der Daten mit einer Hypothese, oft der sogenannten „Null-Hypothese“. Die Nullhypothese besagt, dass es keinen echten Unterschied zwischen zwei Gruppen gibt. Das Ergebnis des Tests ist die Wahrscheinlichkeit dafür, dass man die beobachteten (unterschiedlichen) Daten zufällig erhält, obwohl eigentlich die Null-Hypothese zutrifft. Sie liegt zwischen 0 (trifft nicht zu) und 1 (trifft zu). Ein Beispiel hierfür wäre der Vergleich von Körpergrößen bei Männern und Frauen: Wir messen die Körpergröße von 5 Männern und 5 Frauen und stellen fest, dass die Männer im Mittel etwas größer sind. Die Frage ist nun: Sind Männer wirklich im Schnitt größer als Frauen? Oder haben wir nur zufällig 5 große Männer und 5 kleine Frauen vermessen und daher ein Ergebnis erhalten, das nicht die wahren Verhältnisse repräsentiert?

Signifikante Stellen sind alle Stellen einer Zahl ohne vorangehende Nullen bis zur Rundungsstelle, sie sind also gewissermaßen die „relevanten“ Stellen einer Zahl. Die Angabe „1 Gramm“ wird z.B. nicht genauer, wenn sie als 0,001 kg oder 0,000001 Tonnen ausgedrückt wird. Selbst wenn man 1 g als ca. 0,5*10-33 Sonnenmassen angeben würde, bliebe es noch immer etwa ein Gramm, gerundet auf die letzte ganze „Gramm-Stelle“, also 0,50-1,49 g. Die Zahl vorangehender Nullen sagt also nur etwas über die Größenordnung auf der gewählten Skala aus, nicht über die Genauigkeit der Angabe. 1 hat somit eine signifikante Stelle, ebenso 0,1 und 0,001. Die Zahl 0,100 hingegen hat 3 signifikante Stellen, da Nullen am Ende dazu gezählt werden. Wenn Nullen am Ende nicht signifikant sein sollen, so werden sie weggelassen: 0,2 bedeutet also gewissermaßen „0,15 bis 0,24“, 0,20 bedeutet „0,195 bis 0,204“. Was aber ist zu tun, wenn nachfolgende Nullen nicht signifikant sind, aber auch nicht weggelassen werden können, weil sie z.B. wie bei der Zahl 100 vor dem Komma stehen? In einem solchen Fall kann die Einheit geändert werden oder eine Angabe in Zehnerpotenzen erfolgen: Wenn wir ausdrücken möchten, dass ein Apfel etwa 150 g wiegt (im Sinne von 145 bis 154 g), so lässt sich dafür 0,15 kg schreiben oder 1,5 x 10² g. Eine solche Schreibweise kann auch sehr kleine Zahlen lesbarer machen. Wer 0,000000025 liest, müsste, um die Größenordnung der Zahl abschätzen zu können, die vorangehenden Nullen zählen.

2,5 x 10-8 ist eine deutlich schneller zu erfassende Alternative.

Hier kommt die sogenannte statistische Signifikanz ins Spiel. In der Regel lässt sich nämlich anhand der Streuung der Werte innerhalb einer Gruppe und den Unterschieden zwischen den Gruppen abschätzen, wie wahrscheinlich es ist, dass alles nur „Zufall“ war. Vereinfacht gesagt: In zuvor genanntem Beispiel ist es vielleicht denkbar, zufällig 5 große Männer und 5 kleine Frauen zu messen, obwohl es gar keinen echten Geschlechterunterschied bei der Körpergröße gibt. Wenn aber hunderte Männer im Mittel eher größer sind als hunderte Frauen, so ist es eher unwahrscheinlich, dass man nur seine Messobjekte „unglücklich gewählt“ hat. Auch wenn alle beobachteten Männer ziemlich genau 1,90 m (1,89-1,91 m) sind und alle Frauen ziemlich genau 1,70 m (1,69-1,71 m), würde man eher geneigt sein zu glauben, dass an der Vermutung, Männer seien im Schnitt größer wirklich etwas dran ist.

Die statistische Signifikanz trifft eine Aussage über genau diese Wahrscheinlichkeit und berechnet sie aus dem Datenmaterial selbst. In der Wissenschaft hat sich die Konvention durchgesetzt, dass ein Unterschied zwischen zwei Gruppen dann als statistisch signifikant gewertet wird, wenn die Wahrscheinlichkeit, dass das Ergebnis durch Zufall zustande gekommen ist, unter 5% (p<0,05) liegt. Daraus folgt aber auch: Ein signifikanter Unterschied bedeutet keineswegs, dass dieser tatsächlich existiert. Ein „statistisch signifikanter“ Unterschied bedeutet nur, dass es einigermaßen unwahrscheinlich ist, die Ergebnisse in dieser Form als reinen Zufallsbefund zu erhalten. Sicher können wir uns in der Wissenschaft erst sein, wenn mehrere unabhängige Experimentatoren die Ergebnisse einer Studie reproduzieren konnten und z.B. andere Daten die Erkenntnisse einer Studie unterstützen.

Wie ist also mit p-Werten umzugehen?

Wenn wissenschaftliche Daten für das Marketing verwendet werden, sollten wir vor allem im Hinterkopf behalten, dass statistische Signifikanz eine reine Wahrscheinlichkeitsangabe darstellt. Es gibt kein Schwarz und Weiß diesseits und jenseits der 0,05 sondern einen recht breiten Bereich von dunklem und hellem Grau umgeben von verwaschenem Schwarz und schmutzigem Weiß. Die Grenze von 0,05 ist reine Konvention und ihr Unterschreiten bedeutet nicht, unser gewünschtes Ergebnis sei nun todsicher, sondern nur, dass es unwahrscheinlich (aber nicht unmöglich) ist, dass es nur zufällig zustande gekommen ist. Andersherum hüte man sich aber auch vor dem voreiligen Ausblenden vermeintlich irrelevanter nicht signifikanter Ergebnisse. Denn auch wenn ein Ergebnis mit z.B. p=0,06 nicht signifikant ist, so ist die Wahrscheinlichkeit, dass es vollkommen zufällig zustande gekommen ist, eben doch nur 6%. Das ist von 5% nicht weit entfernt und eine größere Studie oder eine Metaanalyse mehrerer kleiner Studien könnte z.B. den beobachteten Effekt durchaus bestätigen. Die Einordnung des Ergebnisses in den wissenschaftlichen Kontext und der Vergleich mit anderen Studien ist in einem solchen Fall unerlässlich.

Absolut sicher kann man sich also nie über Studienergebnisse sein. Die komplizierte Welt der Statistik suggeriert zwar eine objektive Einschätzung der Qualität von Daten mit p-Werten, doch tatsächlich handelt es sich dabei um Wahrscheinlichkeitsangaben, was gewissermaßen nur eine Art schematisiertes „über den Daumen peilen“ darstellt. Kein p-Wert der Welt entbindet den Leser davon, die Ergebnisse einer Studie selbst zu hinterfragen und auf einer fachlichen Ebene zu beurteilen. Daher ist es sicher eine gute Idee, es mit dem Winston Churchill nachgesagten Ratschlag zu halten: Man traue keiner Statistik, die man nicht selbst gefälscht hat.

Autor: Dr. Aike Schweda

... einklappen

Juni 2016

Genauigkeit

Genauigkeit ist immer gut, oder? Vor allem in der Wissenschaft sind genaue Daten und Berechnungen essentiell. Aber hatten Sie nicht auch schon einmal ein „zu-viel- des-Guten“- Gefühl, wenn der Taschenrechner Zahlen mit bis zu 7 Nachkommastellen auswirft? ...

... weiterlesen

Genauigkeit ist immer gut, oder? Vor allem in der Wissenschaft sind genaue Daten und Berechnungen essentiell. Aber hatten Sie nicht auch schon einmal ein „zu-viel- des-Guten“- Gefühl, wenn der Taschenrechner Zahlen mit bis zu 7 Nachkommastellen auswirft? Tatsächlich ist es so, dass die meisten der Nachkommastellen nicht erforderlich oder sogar falsch sind.

Was Zahlenangaben bedeuten

Um zu verstehen, wieviel Genauigkeit Sinn macht, müssen wir zuerst verstehen was Zahlen überhaupt bedeuten, und welche Nachkommastellen bei Zahlenangaben relevant sind. Wenn ein Mensch z.B. 82 kg wiegt, so ist damit gemeint, dass er auf 1 Kilogramm genau gewogen wurde, tatsächlich wiegt er also zwischen 81,5 und 82,4 kg. Um klarzumachen, dass der Mensch wirklich exakt 82 kg wiegt, müssten wir z.B. 82,000 kg schreiben. Das Beispiel suggeriert, dass offenbar die Zahl der Nachkommastellen ausschlaggebend für die Genauigkeit einer Zahlenangabe ist. Tatsächlich aber sind nicht die Nachkommastellen bestimmend, sondern die sogenannten signifikanten Stellen.

Signifikante Stellen

Signifikante Stellen sind alle Stellen einer Zahl ohne vorangehende Nullen bis zur Rundungsstelle, sie sind also gewissermaßen die „relevanten“ Stellen einer Zahl. Die Angabe „1 Gramm“ wird z.B. nicht genauer, wenn sie als 0,001 kg oder 0,000001 Tonnen ausgedrückt wird. Selbst wenn man 1 g als ca. 0,5*10-33 Sonnenmassen angeben würde, bliebe es noch immer etwa ein Gramm, gerundet auf die letzte ganze „Gramm-Stelle“, also 0,50-1,49 g. Die Zahl vorangehender Nullen sagt also nur etwas über die Größenordnung auf der gewählten Skala aus, nicht über die Genauigkeit der Angabe. 1 hat somit eine signifikante Stelle, ebenso 0,1 und 0,001. Die Zahl 0,100 hingegen hat 3 signifikante Stellen, da Nullen am Ende dazu gezählt werden. Wenn Nullen am Ende nicht signifikant sein sollen, so werden sie weggelassen: 0,2 bedeutet also gewissermaßen „0,15 bis 0,24“, 0,20 bedeutet „0,195 bis 0,204“. Was aber ist zu tun, wenn nachfolgende Nullen nicht signifikant sind, aber auch nicht weggelassen werden können, weil sie z.B. wie bei der Zahl 100 vor dem Komma stehen? In einem solchen Fall kann die Einheit geändert werden oder eine Angabe in Zehnerpotenzen erfolgen: Wenn wir ausdrücken möchten, dass ein Apfel etwa 150 g wiegt (im Sinne von 145 bis 154 g), so lässt sich dafür 0,15 kg schreiben oder 1,5 x 10² g. Eine solche Schreibweise kann auch sehr kleine Zahlen lesbarer machen. Wer 0,000000025 liest, müsste, um die Größenordnung der Zahl abschätzen zu können, die vorangehenden Nullen zählen.

2,5 x 10-8 ist eine deutlich schneller zu erfassende Alternative.

Was passiert, wenn wir mit ungenauen Zahlen rechnen?

Messungen lassen sich nicht unendlich genau ausführen. Wie wir die Genauigkeit eines Messergebnisses anzeigen können, haben wir im vorherigen Absatz gelernt. Was aber passiert, wenn wir mit naturgemäß fehlerbehafteten Messwerten weitere Werte rechnen? Das Ergebnis einer Berechnung kann nicht „genauer“ werden als ihre Ausgangswerte. Daher bekommt bei einer Addition oder Subtraktion das Ergebnis so viele Nachkommastellen, wie die Zahl mit den wenigsten Nachkommastellen, die in die Berechnung eingeflossen ist. Wenn ein Erwachsener, der 81,5 kg wiegt, einen Apfel von 0,15 kg in die Hand nimmt, wiegen beide zusammen folglich 81,7 kg. Gerundet wird immer das Ergebnis am Schluss und nicht die in die Berechnung einfließenden Zahlen. Das Ergebnis einer Multiplikation oder Division hat hingegen so viele signifikante Stellen, wie die Zahl mit den wenigsten signifikanten Stellen in der Berechnung. Dabei ist zu beachten, dass die Angabe eine Anzahl mit Hilfe der natürlichen Zahlen exakt ist. 2 Äpfel sind exakt 2,0… (mit unendlich vielen Nullen). Wenn wir den Preis eines Apfels pro kg berechnen wollen und ein Apfel von 152 g oder 0,152 kg kostet 49 Cent, dann hat das Ergebnis höchstens die zwei signifikanten Stellen des Preises. In diesem Fall also z.B. nicht 322 Cent pro kg Äpfel sondern besser 0,32 €/kg.

Wie viele Stellen brauchen wir tatsächlich?

Bei allen Überlegungen zur Genauigkeit von Zahlen sollte man sich auch darüber Gedanken machen, welche Genauigkeit aus rein praktischen Gründen überhaupt relevant ist. Denn auch die „sinnvolle“ Genauigkeit kann von der „zahlentechnisch möglichen“ abweichen. So werden Gewichtsangaben von Menschen in der Regel in (ganzen) Kilogramm angegeben. Zwar gibt es Waagen, die das Gewicht eines Menschen sehr viel genauer bestimmen könnten. Doch die Angabe „der Proband wiegt 87,654 kg“ macht in der Regel nur wenig Sinn, um das (mittlere) Körpergewicht zu charakterisieren. Denn sobald der Proband ein Glass Wasser trinkt, etwas isst, schwitzt oder einem dringenden Bedürfnis nachgeht, wird sich dieses Gewicht ändern. Üblicherweise ist daher zur Charakterisierung des Körpergewichts eines Probanden eine auf 1 kg genaue Angabe ausreichend, selbst wenn genauere Messungen möglich sind.

Fazit

Die Genauigkeit von Zahlenangaben sollte gerade im wissenschaftlichen Umfeld gut durchdacht werden. Nicht jede Nachkommastelle einer Zahl trägt wirklich zur Genauigkeit der Angabe bei oder suggeriert sogar eine Genauigkeit, die eine Zahl gar nicht hergeben kann.

Autor: Dr. Aike Schweda

... einklappen

März 2016

Öffentlichkeitsarbeit im Internet - die Weisheit des Meeres

Deep-Sea News ist ein beliebter Blog mit sehr lesenswerten Beiträgen einer meeresbiologischen Forschungsgruppe. Die Autoren veröffentlichten ihre Erfahrungen mit der Öffentlichkeitsarbeit in mehreren Online-Kanälen im Journal „PLOS Computational Biology“...

... weiterlesen

Deep-Sea News (DSN; http://www.deepseanews.com/) ist ein beliebter Blog mit sehr lesenswerten Beiträgen einer meeresbiologischen Forschungsgruppe. Die Autoren veröffentlichten ihre Erfahrungen mit der Öffentlichkeitsarbeit in mehreren Online-Kanälen im Journal „PLOS Computational Biology“ (http://journals.plos.org/ploscompbiol/article?id=10.1371/journal.pcbi.1003906). Der Artikel mit dem vielversprechenden Titel “Ten Simple Rules for Effective Online Outreach” („Zehn einfache Regeln für effektive Öffentlichkeitsarbeit im Internet) ist interessant für Alle, die versuchen, einem breiten Publikum wissenschaftliche Botschaften zu vermitteln. Vieles davon lässt sich auch für die Vermittlung medizinischer Inhalte nutzen. Die Autoren führen ihre Vorgehensweise sehr anschaulich aus:

Der erste Schritt zu Beginn eines jeden Blogs ist eine klare Definition der Ziele und Werte des Blogs. Definiert man diese direkt zu Anfang, ergeben sich zwei Vorteile: Neuer Inhalt kann effizient erstellt werden und der Erfolg des Blogs wird auf Basis der zuvor definierten Ziele messbar. Die DSN-Autoren nahmen diesen Punkt sehr ernst und entwickelten ihr Leitbild und ihre zentralen Werte in einer strategischen Planungssitzung. Das daraus entstandene Leitbild „Demystifying and humanizing science in an open conversation that instills passion, awe, and responsibility for the oceans” („Entmystifizierung und Vermenschlichung der Wissenschaft im offenen Gespräch, das Leidenschaft, Ehrfurcht und Verantwortung für die Ozeane vermittelt“) vermittelt dem Leser bereits eine Ahnung vom Inhalt des Blogs.

Kontinuierliche Updates der Inhalte sind zwingend notwendig, um die bestehende Leserschaft zu halten und im besten Fall zu vergrößern. Es gibt mehrere Möglichkeiten, den damit verbundenen Arbeitsaufwand zu stemmen: Die DSN-Autoren empfehlen, die Öffentlichkeitsarbeit im Internet von Anfang an in die eigenen Forschungsprojekte zu integrieren, um bei minimalem Zeitaufwand den Erfolg zu maximieren. Das Gleiche gilt für das Bloggen in der medizinischen Kommunikation: Es schreibt sich leichter über Themen, die mit aktuellen Projekten verwandt sind, als über ein komplett neues Gebiet. Angehende Blogger sollten außerdem darüber nachdenken, einen Gemeinschaftsblog zu gründen, denn einem Team von Autoren fällt es wesentlich leichter als einem Einzelkämpfer, regelmäßig neue, originelle Inhalte zu erstellen.

Um möglichst viele Leser effektiv zu erreichen, müssen Stil und Stilmittel der Zielgruppe angepasst werden. Die Verwendung von Internetphänomenen und Videos – wie von DSN praktiziert – ist gut geeignet, um Wissen bei Nicht-Fachleuten zu verbreiten. Medizinische Themen sind allerdings sensibler und manche Internetphänomene daher wenig geeignet, um Patienten und Fachkreise zu erreichen. Die Einbindung der Textaussagen mit Illustrationen und Grafiken ist dabei immer eine gute Idee.

Die Gesamtheit eines Blogs – seine Ziele, Werte und visuelle Anmutung – formt eine Marke und schafft einen Wiedererkennungswert, der die Zielgruppe mit der Marke verbindet. Da die Leser Konsistenz erwarten, sollte der gesamte Inhalt des Blogs einem klaren, wiedererkennbaren Stil folgen. In der medizinischen Kommunikation ist dies besonders wichtig, da ein einheitliches Format und ein konsistenter Stil auch die Vertrauenswürdigkeit einer Informationsquelle vermitteln. Texte in unterschiedlichen Stilen und Formaten könnten hingegen als weniger glaubwürdig wahrgenommen werden.

Da die meisten Leser nur ein oder zwei Online-Plattformen nutzen, empfiehlt DSN, die Inhalte des Blogs über mehrere Plattformen zu verbreiten. Für die medizinische Leserschaft sind LinkedIn und ResearchGate eventuell besser geeignet als Twitter oder Facebook. Die einzelnen Autoren sollten sich auf individuelle Plattformen spezialisieren, um schnell auf Leserkommentare zu antworten und so eine Diskussion zu fördern. So können Leser motiviert werden, den Blog wiederholt zu besuchen.

Das Sammeln und Bewerten von Besucherzahlen und Metriken sozialer Medien hilft, die erfolgreichsten Blogeinträge zu identifizieren. Obwohl es schwer vorhersagbar ist, welche Beiträge am interessantesten für die Leser sind, kann das Monitoring über einen längeren Zeitraum aufzeigen, was am besten funktioniert. Die DSN-Autoren empfehlen eine Textlänge von 400 bis 800 Wörtern, reichhaltig illustriert mit Bildern und Videos. Texte in der medizinischen Kommunikation sind zwar tendenziell länger, jedoch schätzen alle Leser, die nach neuen relevanten Informationen suchen, einen klaren und kompakten Stil.

Wie das Bloggen über Meeresbiologie macht ein Blog über medizinische Themen den oder die Blogger für Öffentlichkeit, Medien und Kollegen sichtbar. Darüber hinaus kann ein gut gepflegter Blog zu einer vertrauenswürdige Informationsquelle für Medien, Öffentlichkeit und Fachkreise werden. Online-Interaktionen können auch neue Ideen und Kooperationen fördern, welche letztlich zu neuen Projekten für die Autoren führen.

Autor: Dr. Mario Pahl

... einklappen

September 2015

Hat sich Ihr Advisory Board gelohnt?

Sind Sie an der Organisation oder an der Leitung von Advisory Boards beteiligt? Falls ja, fragen Sie sich wahrscheinlich auch von Zeit zu Zeit, ob das Resultat im Verhältnis zu dem Geld und der Zeit stehen, die sie investiert haben...

... weiterlesen

Sind Sie an der Organisation oder an der Leitung von Advisory Boards beteiligt? Falls ja, fragen Sie sich wahrscheinlich auch von Zeit zu Zeit, ob das Resultat im Verhältnis zu dem Geld und der Zeit stehen, die sie investiert haben. Häufig gibt es Stolperfallen, die verhindern, dass wir den größtmöglichen Nutzen aus Advisory Boards ziehen. Wie kann man diese Fallen vermeiden? Hier einige Ideen dazu:

Die Teilnehmer liefern nur wenige neue Erkenntnisse

Das ist häufig dann der Fall, wenn es sich um ein Advisory Board mit „Alten Hasen“ handelt (Bei vielen Advisory Boards, an denen ich teilnehme, gibt es nur ein bis zwei Quotenfrauen), welches sich in regelmäßigen Zeitabständen trifft. In anderen Fällen kann es eine unausgesprochene Regel geben, nur „Freunde“ zu kontaktieren. In beiden Fällen haben die Teilnehmer oft langjährige Beziehungen zu den Initiatoren des Advisory Boards, weshalb sie dazu neigen, so zu denken und zu handeln wie die Initiatoren es für richtig halten. Eine solche Gruppe kommuniziert nicht mehr dynamisch, denn über die Zeit hat jedes Mitglied seine feste Rolle gefunden– häufig gibt es dabei ein oder zwei Alphatiere, denen die restlichen Mitglieder des Boards mehr oder weniger folgen.

Wenn es „politische“ oder logistische Gründe für ein festgelegtes Advisory Board gibt, ist es wichtig, neue Erkenntnisse zu liefern, um eine Diskussion anzuregen. Außerdem sollte man überlegen, externe Redner aus verschiedenen Fachbereichen, wie z.B. einen Experten für Pharmakoökonomie zu einem medizischen Advisory Board, einzuladen. Das fordert die Mitglieder des Boards heraus und belohnt sie mit Informationen, die neu für sie sind. Dadurch können sie Ihren Blickwinkel erweitern, um eine andere Sichtweise auf Probleme zu erhalten, die sie momentan beschäftigen. Unterschätzen Sie nicht die exzellenten Fachkenntnisse Ihrer Firma über Themen, die auch für die Berater relevant sind. Dazu gehören beispielsweise Produktentwicklung, Pharmakologie und Gesundheitspolitik. Sie werden erstaunt sein, wie interessant solche Informationen für Experten sind. Allerdings sollten die Referenten offen antworten und nicht versuchen, Informationen bei genauerer Nachfrage zurück zu halten.

Die Teilnehmer diskutieren die Themen auf der Agenda nicht oder unvollständig

Wenn der Zeitplan zu viel Raum für eigene Prioritäten der Teilnehmer lässt, beginnen diese gerne mit fundamentalen wissenschaftlichen Diskussionen, oder Anekdoten über den letzten Kongress. Gerade für hochrangige Meinungsbilder bieten Advisory Boards eine der wenigen Möglichkeiten, sich in entspannter Atmosphäre zu treffen. Das kann sie dazu verleiten, ins Plaudern zu geraten.Die eigenen Fragen sollten offen an das Advisory Bord gestellt werden. Die Experten werden durchaus bereit sein, sich führen zu lassen. Allerdings sollten die Fragestellungen in einer Art und Weise dargestellt werden, die es ermöglicht, sie präzise zu beantworten. Wenn es sich beispielsweise um ein Problem des Market Access handelt, kann es hilfreicher sein, seine eigenen Ideen zur Problemlösung zu präsentieren, als theoretische Fragen zu dem Thema zu stellen.

Überlegen Sie, die Statements der Experten sofort auf Power Point Folien zu schreiben und diese an die Wand zu projizieren. So sind die Aussagen für alle präsent und diejenigen, die möglicherweise anderer Meinung sind, werden eher dazu angeregt, in die Diskussion einzusteigen. Ein sichtbares Feedback auf ihre Aussagen bringt die Experten auch eher dazu einen Konsens zu finden, oder es lässt sie zumindest eine Mehrheitsmeinung erkennen. Dadurch zeigt sich, ob alle Teilnehmer tatsächlich mit einer Aussage übereinstimmen, die eines der Alphatiere aufgebracht hat, oder ob es abweichende Meinungen gibt.

Die Resultate des Advisory Boards sind nicht so dokumentiert, dass sie für einen weiteren Gebrauch verwendet werden können

Häufig machen sich alle Vertreter der Initiatoren Notizen während des Advisory Boards und dann wird ein offizieller Protokollant ausgewählt. Wenn das Protokoll dann verteilt wird, stellt sich heraus, dass es grundlegende Diskrepanzen beim Verständnis der Expertenaussagen gibt. Stellen Sie deswegen sicher, dass es eine Tonaufzeichnung der Veranstaltung gibt. Die Experten sollten allerdings vorher gefragt werden, ob sie mit der Tonaufzeichnung der Diskussion einverstanden sind. Wenn Sie darauf hinweisen, dass die Aufzeichnung dazu dient, den Verlust von wertvollen Informationen zu verhindern und versichern, die Tonaufzeichnung nach Fertigstellung des Protokolls zu löschen, werden sie höchstwahrscheinlich zustimmen. Eine Diskussion bei einem Advisory Board erneut anzuhören, ist eine erstaunliche Erfahrung. Aussagen, die Sie für eindeutig und klar hielten, wirken beim erneuten Anhören des originalen Wortlauts weniger überzeugend. Das ist häufig auf die Erwartungshaltung zurück zu führen, die Sie und Ihre Kollegen an das Treffen hatten.

Darüber hinaus sollte man die Experten darum bitten, Fragen, die im Nachgang auftreten, zu beantworten. Das verhindert, dass Sie mit zu vielen neuen Fragen aus dem Treffen herausgehen und kann dabei helfen herauszufinden, ob manche Experten ihre abweichenden Meinungen nicht klar genug zum Ausdruck gebracht haben.

Sie müssen sich also nicht zurückhalten, wenn es darum geht, für Ihr Geld auch die Leistung der Experten einzufordern. Mit einer guten Balance zwischen den eigenen Forderungen und der kreativen Freiheit der Experten, werden Sie sicher Ergebnisse mit Ihrem Advisory Board erzielen können, die für Sie lohnend sind.

Autor: Dr. Christoph Messer

... einklappen

Juni 2015

Wo man "echte Evidenz" findet

Der Artikel “Evolution of evidence-based medicine to detect evidence mutations”, von Alpers et al., der im “Journal of the Royal Society of Medicine” (J R Soc Med 2015; 108: 8–10) erschienen ist, scheint evolutionäre Mechanismen zur Erklärung sozialer ...

... weiterlesen

Der Artikel “Evolution of evidence-based medicine to detect evidence mutations”, von Alpers et al., der im “Journal of the Royal Society of Medicine” (J R Soc Med 2015; 108: 8–10) erschienen ist, scheint evolutionäre Mechanismen zur Erklärung sozialer Phänomene zu nutzen. Ein Ansatz dem ich misstraue, da er schnell in verdrehten Konzepten wie dem Sozialdarwinismus resultiert. Allerdings benutzen die Autoren die Anspielung auf die Genetik elegant als Rahmen, um Beispiele unausgewogener wissenschaftlicher Beweisführung (biased evidence) in der Medizin zu veranschaulichen. Als Beispiele nennen die Autoren Studiendaten, die in FDA-Gutachten verborgen sind, aber nie publiziert wurden, da sie nicht mit den Marketing-Claims zum Produkt passen. Studien eines Wissenschaftlers, dem wissenschaftliches Fehlverhalten nachgewiesen wurde, die aber nie von den wissenschaftlichen Zeitschriften zurückgezogen wurden. Oder Daten, die mehrfach in verschiedenen Zeitschriften veröffentlicht wurden. Dies führt dazu, dass Metaanalysen wichtige Studien nicht berücksichtigen oder ungültige Daten mit einbeziehen. Anderen Einflussfaktoren auf Metaanalysen, die die Autoren diskutieren , sind weniger eindeutig: Studien, mit Patienten, die nicht repräsentativ für die untersuchte Indikation sind, dürften eher die Regel als die Ausnahme sein, wenn man bedenkt, dass alte und multimorbiden Patienten aus vielen Studien ausgeschlossen werden. Mit dem schönen Ausdruck der „akademischen Inzucht“ wird charakterisiert, dass hauptsächlich eine Arbeitsgruppe Ergebnisse zu einem Wissensgebiet liefert. Dieses Phänomen gibt es sicherlich, andererseits werden viele Themen außerhalb des medizinischen Mainstreams nur von einer kleinen Gruppe Wissenschaftlern bearbeitet.

Tatsache ist, dass es noch viele weitere potentielle Einflussfaktoren bei der Studienauswahl für Metaanalysen gibt, die die Ergebnisse genauso verfälschen können wie eine unklare Datenlage. Beispiele dafür sind Sprachbarrieren bei der Suche nach Studien, der Einschluss von Studien, über eine längere Zeitspanne, innerhalb derer sich die Begleittherapie substantiell verändert hat oder unterschiedliche Endpunktdefinitionen in verschiedenen Studien. Schließlich gibt es neben dem Tod nur wenige klinische Endpunkte, bei denen Spielraum in der Diagnosestellung besteht.

Eine eindeutig korrekte Auswahl von Studien für Metaanalysen wird daher sehr selten möglich sein und verschiedene Autoren werden ein unterschiedliches Maß an Heterogenität für einzelne Parameter akzeptieren. Aus diesem Grund stimme ich nicht mit dem Standpunkt der Autoren überein, dass es zu viele Metaanalysen auf den meisten Gebieten gibt – einmal abgesehen von extremen Situationen, in denen es genauso viele Metaanalysen wie Studien gibt, ausgenommen:(http://www.bmj.com/rapid-response/2011/11/03/too-many-meta-analyses). Mehrere Metaanalysen zu einem Thema, die zu verschiedene Ergebnisse kommen, zeigen vor allem, dass das Thema nicht ausreichend untersucht ist.

Um auf die unausgewogene wissenschaftliche Beweisführung, die von Alpers et al. als „Evidenz-Mutationen“ bezeichnet werden, zurück zu kommen, verhält es sich damit tatsächlich genauso wie mit genetischen Mutationen. Sie können gesunde unterschiedliche Blickwinkel auf ein Thema eröffnen, oder Ausdruck einer ungehemmten Proliferation dysfunktioneller Daten sein. Am Ende lässt sich das nur herausfinden, wenn man bereit ist, sich tief in die Thematik einzuarbeiten oder jemand findet, der sich in dem Themengebiet auskennt und dem man vertraut.

Autor: Dr. Christoph Messer

... einklappen

Januar 2015

Wie beurteilt man die Relevanz und Qualität einer Metaanalyse?

Eine Metaanalyse oder auch eine andere systematische Zusammenfassung hinsichtlich ihrer Aussagekraft zu beurteilen, ist nicht einfach, denn letztendlich beruht ihre Qualität auf der Zuverlässigkeit der eingeschlossenen Studien und einer sinnvollen Auswahl für die Analyse...

... weiterlesen

Eine Metaanalyse oder auch eine andere systematische Zusammenfassung hinsichtlich ihrer Aussagekraft zu beurteilen, ist nicht einfach, denn letztendlich beruht ihre Qualität auf der Zuverlässigkeit der eingeschlossenen Studien und einer sinnvollen Auswahl für die Analyse. Aber es gibt einige grundlegende Punkte, deren Überprüfung einen Hinweis auf die Qualität liefern:

Planung:

Wurden folgende Dinge im Voraus festgelegt?

... bei der Studienauswahl, z.B. nach den PRISMA-Empfehlungen: http://www.prisma-statement.org/statement.htm

... Untersuchte Fragestellung – wer aufs Geratewohl sucht, wird auch irgendwann fündig.

... Ein- und Ausschlusskriterien für die untersuchten Studien

Durchführung:

... Genaue Beschreibung der Literaturrecherche - Welche Datenbanken wurden durchsucht, wer hat gesucht und wer hat die Studien ausgewählt?

... Verfahren zur Studienauswahl transparent, systematisch und angemessen dargestellt?

... Vorgehen bei der statistischen Auswertung beschrieben?

... Heterogenität zwischen den Studien überprüft und berücksichtigt?

... Ergebnisse der Studien methodisch sauber zusammen geführt?

Wenn beispielsweise das Schmerzempfinden in mehreren Studien mit verschiedenen kontinuierlichen Skalen erfasst wurde, kann es nicht direkt verglichen werden. Stattdessen muss zunächst für jede Studie die standardisierte Mittelwertsdifferenz berechnet werden (mittlere Differenz zwischen den Behandlungsgruppen geteilt durch die Standardabweichung). Diese standardisierte Mittelwertsdifferenz ist unabhängig von der ursprünglichen Skala und erlaubt daher den Vergleich verschiedener Studien.

Ergebnisse:

... Unterschiede bei den Wirkgrößen auch klinisch relevant? Ein Unterschied im Blutverlust von 70 ml kann statistisch relevant sein, aber klinisch ist er bei Erwachsenen bedeutungslos.

... Beeinflusst eine Studie das Ergebnis der Metaanalyse sehr stark aufgrund Ihrer Größe? Wurde geprüft, wie sich die Ergebnis ohne diese Studie ändern?

Diskussion:

... Diskussion der Limitationen der Metanalyse? Beschreiben die Autoren, in wie weit diese Limitationen die Aussagekraft ihrer Analyse einschränken?

... Ist das, was die Autoren in der Schlussfolgerung behaupten, auch aus den präsentierten Ergebnissen ableitbar?

Wenn mehrere Fragen verneint werden müssen, sollten die Ergebnisse der Metaanalyse kritisch hinterfragt werden. Sauber durchgeführt kann eine Metaanalyse jedoch sehr aufschlussreich sein, beispielsweise wenn es zu einer Fragestellung mehrere sehr kleine Studien gibt, die für sich genommen keine Signifikanz erreichen, in der Summe aber durchaus große Relevanz haben können.

Autor: Dr. Miriam Imo

... einklappen

Januar 2014

Wie liest man einen forest plot?

Ein Forest Plot - zu Deutsch eine „Waldzeichnung“, wobei man schon viel Fantasie benötigt, um darin einen Wald zu erkennen - ist eine Möglichkeit, die Ergebnisse einer Metaanalyse grafisch darzustellen...

... weiterlesen

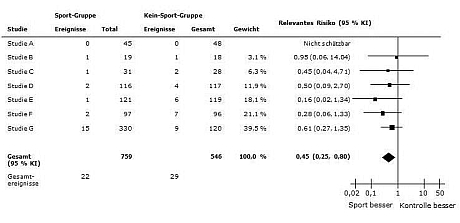

Ein Forest Plot - zu Deutsch eine „Waldzeichnung“, wobei man schon viel Fantasie benötigt, um darin einen Wald zu erkennen - ist eine Möglichkeit, die Ergebnisse einer Metaanalyse grafisch darzustellen. Auf den ersten Blick sieht ein Forest Plot zwar alles andere als übersichtlich aus, mit etwas Übung lassen sich aber das Ergebnis jeder einzelnen Studie, deren Einfluss auf das Gesamtergebnis und das Gesamtergebnis sofort erfassen.

Schauen wir uns einen Forest Plot an:

Quelle: Thomas S et al. Age Ageing 2010; 39: 681-687

In diesem Beispiel wurde untersucht, welche Auswirkungen ein Sportprogramm auf die Mortalität hat.

Alle Studien, die in die Metaanalyse eingebunden sind, werden untereinander aufgelistet und in der Grafik rechts durch eine horizontale Linie und ein Quadrat dargestellt. Die Mitte des Quadrats zeigt das Ergebnis der jeweiligen Studie.

Ganz links steht normalerweise der Erstautor der Studie, hier nur als „Studie A“ usw. gekennzeichnet. Bei Studie A gab es in beiden Gruppen keine Todesfälle (Spalte „Ereignisse“), daher kann das Mortalitätsrisiko nicht berechnet werden und die Studie wird für die Metaanalyse dieses Endpunktes nicht berücksichtigt.

Bei Studie B gab es in der Sport-Gruppe einen Todesfall (Spalte „Ereignisse“) bei insgesamt 19 Probanden in der Gruppe (Spalte „Gesamt“). In der Gruppe ohne Sportprogramm („Kein-Sport-Gruppe“) gab es ebenfalls einen Todesfall bei 18 Probanden. Das Mortalitätsrisiko mit Sportprogramm beträgt daher für diese Studie ((1/19)/(1/18)) = 0,95.

Ein Verhältnis von 1 bedeutet, dass das Mortalitätsrisiko in beiden Gruppen gleich hoch ist. Dies wird durch die vertikale Mittellinie oder „Kein-Effekt-Linie“ durch die 1 dargestellt. Bei einem Verhältnis unter 1 ist in diesem Beispiel die Überlebensrate in der Sportgruppe besser, daher steht auf der linken Seite der Mittellinie „Sport besser“. Bei einem Verhältnis über 1 wäre die Gruppe ohne Sportprogramm, d.h. die Kontrollgruppe besser, verdeutlicht durch „Kontrolle“ auf der rechten Seite. Je weiter ein Quadrat von der Mittellinie entfernt ist, desto stärker war der Effekt in der Studie.

Die Größe des Quadrats repräsentiert die Bedeutung (das „Gewicht“) der Studie für das Gesamtergebnis. Hier hat beispielsweise Studie G das größte Gewicht, da sie mit 450 Probanden die größte Studie war. Da es in Studie B nur 37 Probanden gab, wird das Ergebnis durch ein deutlich kleineres Quadrat dargestellt. Wie stark eine Studie genau gewichtet wird, kann in der Spalte „Gewicht“ abgelesen werden. Durch die unterschiedliche Gewichtung ist es möglich, in einer Metaanalyse Studien unterschiedlicher Größe zu berücksichtigen.

Die Länge der horizontalen Linien hinter den Quadraten zeigt das Konfidenzintervall an. Hier kommt wieder die „Kein-Effekt-Linie“ ins Spiel. Wenn die Linie der Einzelstudie diese Mittellinie schneidet, ist das Ergebnis der Einzelstudie nicht signifikant (5 %-Niveau). Befindet sich dagegen die komplette Linie auf einer Seite der Mittellinie, handelt es sich um einen signifikanten Effekt.

Das jeweilige Konfidenzintervall wird in der Spalte „Relatives Risiko“ in Klammern hinter dem Risikoverhältnis angegeben. In diesem Beispiel ist keine der Einzelstudien signifikant, da das Konfidenzintervall bei allen die 1 einschließt, d.h. die horizontale Linie schneidet die „Kein-Effekt-Linie“. Alle Studien zeigen zwar den gleichen Trend, denn alle Quadrate befinden sich links der Linie, allerdings ist die Stichprobengröße in jeder einzelnen Studie zu gering, um einen Zufallseffekt auszuschließen.

Wo steht das Gesamtergebnis?

Die Raute unter den Einzelstudien zeigt das Gesamtergebnis der Metaanalyse. Durch die Lage des Mittelpunktes ist sofort ersichtlich, ob die Intervention oder die Kontrolle besser ist. Das Konfidenzintervall des Gesamtergebnisses wird durch die äußeren Punkte der Raute dargestellt.

Durch die gemeinsame Betrachtung aller Studien in einer Metaanalyse wird die Stichprobe groß genug, um ein signifikantes Ergebnis zu zeigen. Die Raute schneidet nicht die Mittellinie, da das Konfidenzintervall (0,25; 0,80) die 1 nicht einschließt. Das heißt durch die gemeinsame Betrachtung aller Studien konnte gezeigt werden, dass das Sportprogramm tatsächlich das Mortalitätsrisiko reduziert.

Achtung: Die Skalierung der Grafik (logarithmisch oder kontinuierlich), die Lage der „Kein-Effekt-Linie“ und die Verteilung von „besser“ und „schlechter“ auf die beiden Seiten der Mittellinie ist abhängig von der jeweiligen Fragestellung und muss der Beschriftung entnommen werden.

In der nächsten Folge wird es darum gehen, wie man die Relevanz der Ergebnisse einer Metaanalyse bewertet.

Autor: Dr. Miriam Imo

... einklappen

November 2013

Harte Endpunkte – weiche Aussagen

Alle wollen sie, wenige haben sie – die „harten Endpunkte“ in Studien. Was es damit auf sich hat und welche Bedeutung der „Härtegrad“ von Endpunkten für die Formulierung von Botschaften aus den Studien hat, soll hier kurz dargelegt werden...

... weiterlesen

Alle wollen sie, wenige haben sie – die „harten Endpunkte“ in Studien. Was es damit auf sich hat und welche Bedeutung der „Härtegrad“ von Endpunkten für die Formulierung von Botschaften aus den Studien hat, soll hier kurz dargelegt werden.

Mit „Endpunkt“ wird in klinischen Studien das Ergebnis einer Behandlung, z.B. Entlassung aus dem Krankenhaus, oder eine bestimmte Diagnose, z.B. Herzinfarkt, bezeichnet. Für eine Interventionsstudie wird vor Studienbeginn festgelegt, welcher Endpunkt untersucht werden soll. Damit wird die Gefahr reduziert, dass nach Studienende nur die Ergebnisse ausgewählt werden, die den Studienautoren ins Konzept passen oder interessant erscheinen. Da Studien aber mit erheblichem Aufwand verbunden sind, definiert man meist neben einem Haupt-Endpunkt (primärer Endpunkt) weitere sekundäre Endpunkte z.B. um eine Strukturierung der Ergebnisse zu ermöglichen. Ein Beispiel wäre „Tod“ als primärer Endpunkt und „kardiovaskulär bedingter Tod“ sowie „sonstige Todesursachen“ als sekundäre Endpunkte.

Als primären Endpunkt wählen die Studienplaner den aus ihrer Sicht wichtigsten; bei schweren, rasch fortschreitenden Erkrankungen wird

das der Tod sein. Dies ist der klassische „harte“ Endpunkt, da es keinen

Interpretationsspielraum bei der Diagnose gibt und seine Relevanz unstrittig ist. Es gibt Verfechter der These, dass nur das Dahinscheiden ein wirklich harter Endpunkt ist, weil man nicht „ein bisschen tot“ sein kann. Allgemein akzeptiert ist aber die Ansicht, dass Endpunkte umso „härter“ sind, je wichtiger das Ereignis im Krankheitsverlauf ist und je eindeutiger die Diagnosekriterien sind. Denn manche Diagnosen, z.B. Herzinsuffizienz, sind durchaus schwerwiegend, aber besonders in frühen Stadien nicht ganz einfach zu diagnostizieren. Hier besteht also die Gefahr, dass aufgrund der Schwierigkeiten bei der Diagnosestellung die beobachtete Ereignishäufigkeit nicht der Realität entspricht.

Für die Nutzung von Endpunkten zur Kommunikation kann man sich also zuerst an der „Härte“ der Endpunkte orientieren. Wird beispielsweise der Krankheitsverlauf von Dialysepatienten untersucht und dabei Appetitverlust, Puritus (Juckreiz) und Gewichtsabnahme als Endpunkte erfasst, steigt die „Härte“ der Endpunkte in dieser Reihenfolge. Die beiden erstgenannten Endpunkte hängen stark vom subjektiven Empfinden der Patienten ab, wodurch die Diagnose einen höheren Interpretations- spielraum aufweist. Für die Beurteilung des Appetitverlustes ist der Arzt ganz auf die Aussage des Patienten angewiesen und kann nicht objektiv prüfen, wie sich der Appetitverlust äußert. Bei Juckreiz sind aber für den Arzt möglicherweise Symptome in Form von Kratzspuren erkennbar, daher ist er hier im Gegensatz zum Endpunkt „Appetit“ nicht ausschließlich auf die Aussage des Patienten angewiesen. Der Gewichtsverlust ist hingegen objektiv messbar, sofern geeichte Waagen verwendet werden, und kann bei dem Patienten am Beginn eines allgemeinen körperlichen Abbaus stehen, der den gesamten Krankheitsverlauf negativ beeinflusst. Damit ist dieser Endpunkt der klinisch wichtigste und diagnostisch am eindeutigsten.

Wenn sich nun in einer Studie zu Supplement X zeigt, dass alle drei Endpunkte positiv beeinflusst werden, wäre dann die geringere Gewichtsabnahme die Kernbotschaft für die Ärzte? Was die Validität der Endpunkte betrifft, ja; aber nun kommen weitere Punkte ins Spiel, denn die „Härte“ eines Endpunktes spiegelt nicht unbedingt die Bedeutung für die Zielgruppe wieder. In unserem Beispiel löst der Gewichtsverlust zu Beginn einer Dialysebehandlung eher geringen Leidensdruck bei Patienten und Ärzten aus. Wahrscheinlich werden mehr Ärzte aufhorchen bei der Botschaft zum Juckreiz. Das Problem ist seltener, aber der Leidensdruck kann erheblich sein – für Patient und Arzt. Die Härte eines Endpunktes ist daher ein wichtiger, aber nicht der einzige Aspekt, den man bei der Kommunikation berücksichtigen sollte.

Autor: Dr. Christoph Messer

... einklappen

September 2013

Juhuu, unsere Studie wurde abgesagt

Medizinische Studien sind Experimente an Menschen. Da Menschen eine bessere Lobby haben als Laborratten, wird sehr genau darauf geachtet, dass dabei niemand zu Schaden kommt...

... weiterlesen

Medizinische Studien sind Experimente an Menschen. Da Menschen eine bessere Lobby haben als Laborratten, wird sehr genau darauf geachtet, dass dabei niemand zu Schaden kommt. Daher muss eine Studie sehr aufwendig geplant, genehmigt und überwacht werden. Dabei wird zu Beginn einer Studie festgelegt, wann zum ersten Mal auf statistisch signifikante Unterschiede zwischen den Behandlungsgruppen geprüft wird. Zeigt sich nämlich bei diesen Zwischenauswertungen, dass die getestete Therapie schlechter ist als die bisherige, kann das Sicherheitskomitee der Studie entscheiden, die „Notbremse zu ziehen“ und die Studie abzubrechen, um Schaden von den Patienten abzuwenden. Allerdings kann sich bei solchen Gelegenheiten auch schon das erhoffte Ergebnis zeigen, dass nämlich die neue Therapie der alten überlegen ist.

Dann ist der Jubel groß: Die neue Therapie hat einen größeren Effekt als erwartet - schließlich hatte man ja vermutet, dass mehr Patienten nötig sind, um den Effekt zu zeigen - und man hat die positiven Ergebnisse früher als erhofft. Jetzt kann man mit dem wissenschaftlichen Marketing voll durchstarten – oder?

Das ist alles richtig, und jeder Studiensponsor ist völlig im Recht, wenn er die Daten in seinem Sinne nutzt. Er sollte sich nur im Klaren darüber sein, dass eine vorzeitig beendete Studie weniger verlässliche Daten liefert als eine planmäßig beendete. Zu diesem Ergebnis sind z.B. auch H. Guyatt und Kollegen gekommen, die im British Medical Journal dazu publiziert haben (http://www.bmj.com/content/344/bmj.e3863 ).

Die Autoren beschreiben drei Therapien, bei den vorzeitig abgebrochene Studien zu Therapieempfehlungen geführt haben, die später zurückgenommen werden mussten:

... Der perioperative Einsatz des Betablockers Bisoprolol bei nicht-kardialen Patienten,

... Die strenge Einstellung des Blutzuckers bei kritisch Kranken und

... Die Rolle von aktiviertem Protein C bei septischen Patienten

In allen drei Fällen waren Studien, die bei einer Zwischenanalyse einen erheblichen klinischen Nutzen zeigten, vorzeitig abgebrochen worden und hatten sogar zu Leitlinienempfehlungen geführt.

Diese Empfehlungen mussten allerdings später revidiert werden. Die Autoren unterstellen als Grund für die aus ihrer Sicht übereilten Empfehlungen Interessen der industriellen Studiensponsoren und übersteigerter Profilierungswillen von Studienleitern und Leitlinienautoren.

Derlei Überlegungen sind sicher nicht immer von der Hand zu weisen, aber dass der Fortschritt der Medizin auch davon lebt, klinisch relevante Erkenntnisse rasch zu kommunizieren, ist den Autoren leider keine Erwähnung wert.

Welche Schlüsse können daraus für das wissenschaftliche Marketing gezogen werden? Zuerst einmal bleibt die Tatsache, dass eine abgebrochene Studie mit positiven Ergebnissen sehr gut für das Marketing nutzbar ist. Wichtig ist aber, sich immer im Klaren darüber zu sein, dass es sich bei den Ergebnissen einer abgebrochenen Studie um „halbfertige“ Daten handelt und nach Abschluss weiterer Studien sich unter Umständen ein anderes Bild ergeben kann. Die weitere Entwicklung der Studienlage muss daher aktiv im Auge behalten werden. Neue Studien müssen heute in Studienregistern wie clinicaltrials.gov angemeldet werden. Durch regelmäßige Recherchen lässt sich frühzeitig erkennen, welche weiteren Studien zu einem Thema laufen und wie diese die Evidenzlage beeinflussen könnten. Besonders bei Präparaten, die bereits länger im Markt sind, kann ein Blick auf die Studienlage zeigen, ob auch andere Forscher zu ähnlichen Ergebnissen gekommen sind, oder ob das eigene (vorläufige) Ergebnis eventuell kritisch hinterfragt werden sollte. So können Sie sicherstellen, dass der „Schnellschuss“ einer abgebrochenen Studie für Ihr Unternehmen nicht nach hinten losgeht.

Autor: Dr. Christoph Messer

... einklappen